ZK Huge Grouping Model fr"

| (26 intermediate revisions by the same user not shown) | |||

| Line 15: | Line 15: | ||

Sur bases des certains concepts (pagination au niveau de la DB et séparation du contrôle de la pagination de la grid) cet article propose une stratégie et présente un exemple implémenté de comment faire du groupement de données à l'identique. | Sur bases des certains concepts (pagination au niveau de la DB et séparation du contrôle de la pagination de la grid) cet article propose une stratégie et présente un exemple implémenté de comment faire du groupement de données à l'identique. | ||

| − | Cependant, les choses se compliquent ici quelques peu... j'espère donc au final donner une idée de comment | + | Cependant, les choses se compliquent ici quelques peu... j'espère donc au final donner une idée de comment ZK masque les parties compliquées, et laisse le développeur se concentrer sur la récupération et l'affichage des données. |

| − | = | + | =Les défis= |

| − | + | Le Groupement est une caractéristique puissante de ZK mais qui amène aussi une couche supplémentaire de complexité. | |

| − | + | Certains pourraient se demander s'il est utile d'afficher une liste aussi longue de cette manière (en particulier sans pré-filtrage des résultats). | |

| − | + | Nous sommes ici pour montrer que c'est possible possible, jusqu'à quelles limites ... et bien, ZK GroupsModel supporte des index de type int, nous pouvons donc aller jusqu'à environ Integer.MAX_VALUE (~ 2.000.000.000 enregistrements - 2 milliards) | |

| − | == | + | ==Les défis de la pagination et du regroupement== |

| − | 1. | + | 1. Les groupes peuvent être ouverts ou fermés (initialement ou de façon interactive) |

| − | :-> | + | :-> Le nombre total et le nombre de pages changent à l'ouverture/la fermeture des nœuds d'index (nodes)... ceci requiert un comptage efficace et continuellement à jour |

| − | 2. | + | 2. Les groupes peuvent avoir un nombre arbitraire d'enfants |

| − | :-> | + | :-> L'accès aléatoire à une page spécifique peut devenir délicat ... comment connaitre le groupe actuel et la position à l'intérieur de ce groupe pour cette page |

| − | :--> | + | :--> Comment implémenter une recherche réalisable ? |

| − | 3. | + | 3. Minimiser les opérations DB (accumulation des latences réseau/DB) |

| − | :-> | + | :-> Prendre en considération la mise en cache versus la consommation de la mémoire |

| − | 1. + 2. + 3. | + | 1. + 2. + 3. Cet article va expliquer comment combiner ces trois aspects de manière efficace en préservant la mémoire (presque prévisible) et quelques compromis qui doivent être faits. Aussi, quelques points d'extension sont mis en évidence, où, si possible, la mise en oeuvre d'usage général peut être remplacée par une autre plus spécifique, en fonction des détails de votre propre modèle de données. |

| − | == | + | ==Quelques limites== |

| − | * | + | * Cet exemple fonctionne uniquement sur des données statiques - si les données changent, le modèle doit être réinitialisé et les caches doivent être vidées. |

| − | * | + | * Vu que toutes les lignes ne sont pas présentes en mémoire, vous pouvez envoyer des événements UI à des composants qui ne sont pas affichés à l'écran (vous manipulez l'état du modèle à la place) |

| − | * | + | * L'état ouvert/fermé est stocké en mémoire ("les humains ont des limites", il est peu probable de dépasser les 100 groupes) - Il ne devrait donc pas y avoir de problème. |

| − | * | + | * Certains composants "maquettes" sont nécessaires pour que le <grid> accepte la vue limitée (fenêtrée) sur les données. |

| − | = | + | =Implémentation= |

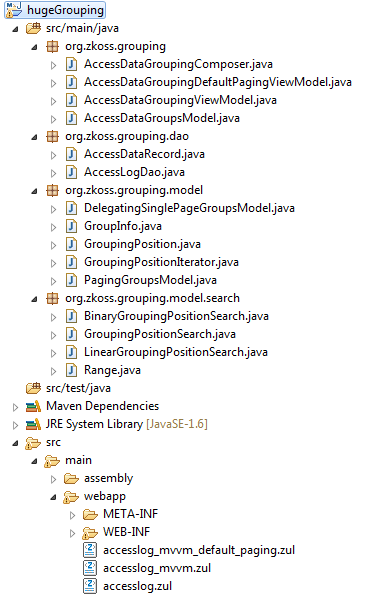

| − | + | Le [[#Download|package exemple]] est un projet maven, avec la structure suivante: | |

[[File:hugeGrouping_files.png]] | [[File:hugeGrouping_files.png]] | ||

| − | + | Le dossier "src" contient les différents fichiers/dossiers/packages: | |

| − | + | Classes génériques (expliqué plus bas): | |

; org.zkoss.grouping.model | ; org.zkoss.grouping.model | ||

| − | : | + | : implémentation pagination générique GroupsModel |

; org.zkoss.grouping.model.search | ; org.zkoss.grouping.model.search | ||

| − | : | + | : implémentation des recherches de positions |

| − | + | Implémentations spécifiques à l'exemple (montrant l'utilisation des éléments ci-dessus) | |

; org.zkoss.grouping.dao | ; org.zkoss.grouping.dao | ||

| − | : | + | : Classe Dao en mémoire qui simule des grosses quantités de données |

; org.zkoss.grouping | ; org.zkoss.grouping | ||

| − | : | + | : Les implémentation du Composer actuel (MVC) / ViewModel (MVVM) et (Dao-backed) PagingGroupsModel |

| − | + | Fichiers ZUL correspondants (dans src/main/webapp): | |

; accesslog.zul | ; accesslog.zul | ||

| − | : MVC | + | : utilisation MVC de PagingGroupsModel |

; accesslog_mvvm.zul | ; accesslog_mvvm.zul | ||

| − | : MVVM | + | : utilisation MVVM de PagingGroupsModel avec DelegatingSinglePageGroupsModel |

; accesslog_mvvm_default_paging.zul | ; accesslog_mvvm_default_paging.zul | ||

| − | : MVVM | + | : Exemple MVVM mettant en évidence les problèmes de performance sans contrôle de pagination séparé, en utilisant un set de données plus petit |

| − | == | + | ==Accéder aux données== |

| − | ===Data Record | + | ===Data Record et Dao=== |

| − | + | Nous commencons avec un simple enregistrement de données représentant des access logs. | |

<source lang="java"> | <source lang="java"> | ||

| Line 97: | Line 97: | ||

</source> | </source> | ||

| − | + | L'AccessDataDao est une implémentation mock générant les données à la volée sans utiliser une DB (juste des valeurs aléatoires) et qui stocke la taille des groupes en mémoire. | |

| − | |||

| − | + | Donc, en oubliant la génération de données aléatoire, votre Dao devrait implémenter les 5 opérations suivantes suivant des requêtes SQL/HQL/Criteria/noSQL. Je suis conscient que compter des grandes quantités de données au niveau de la DB n'est pas chose simple. Il faut toujours préparer les données au niveau de la DB: ex. indexation propre, pré agrégation des groupes/compteurs (rien en quoi le 'front end framework' peut vous aider). | |

<source lang="java"> | <source lang="java"> | ||

| Line 139: | Line 138: | ||

</source> | </source> | ||

| − | === | + | ===Le modèle de pagination=== |

| − | AccessDataGroupsModel, | + | AccessDataGroupsModel, notre PagingGroupsModel<D, H, F> spécialisé utilise une implémentation d'AccessDataRecord comme "data"(D) et String comme "head"(H) et "foot"(F). |

| − | + | Cette classe implémente les 4 méthodes du modèle et une stratégie GroupingPositionSearch - tout en déléguant à AccessLogDao d'en haut, pour garder la charge de travail au niveau de la DB. | |

<source lang="java"> | <source lang="java"> | ||

| Line 199: | Line 198: | ||

</source> | </source> | ||

| − | + | Comme nous pouvons le voir, les méthodes se concentrent sur le comptage et la récupération des données dans des morceaux de la taille d'une page. Rien de magique ici, pendant que notre DB fait le travaille difficile (sélection, groupement, comptage, tri) ... c'est à ça que ça sert. Et avec des grosses quantités de données, nous n'allons pas essayer de battre la DB, nous voulons seulement des données aussi petites que possible. Votre administrateur DB sera heureux de vous aider à optimiser vos requêtes et préparer vos données. ;-) | |

| − | ==Page/Caching, | + | ==Page/Caching, Comptage & conserver l'état ouvert/fermé== |

| − | === | + | ===Conserver l'état ouvert/fermé=== |

| − | + | Le PagingGroupsModel va garder une trace des états ouvert/fermé pour les groupes dont l'état a été modifié (avec en même-temps le childCount de ce groupe). | |

| − | + | Si le Model est initialisé avec INITIALLY_OPEN, alors on gardera la trace uniquement des 'nodes' fermés, et vice versa. | |

| − | + | En supposant qu'un humain ne prendra pas le temps de changer l'état d'un nombre immense de groupes, cette Map (groupIndex => childcount) restera relativement petite et ne devrait pas compromettre notre performance ainsi que nos attentes au niveau de la mémoire. De plus, le nombre total de groupes dont l'état a été modifié est mis à jour à chaque interaction ouvert/fermé. | |

| − | + | Cette information est utilisée pour ajuster le nombre total d'enfants (pour le calcul de pagination UI) ou le nombre d'enfants entre deux groupes (pour la recherche de Position) - vu que la DB ne gardera pas cet état UI. | |

| − | + | Voir: | |

* PagingGroupsModel#getCurrentRowCount() | * PagingGroupsModel#getCurrentRowCount() | ||

* PagingGroupsModel#getToggledCountBetween(int groupIndexFrom, int groupIndexTo) | * PagingGroupsModel#getToggledCountBetween(int groupIndexFrom, int groupIndexTo) | ||

| Line 220: | Line 219: | ||

===Page/Caching=== | ===Page/Caching=== | ||

| − | + | L'interface GroupsModel (ZK default) offre des méthodes pour récupérer les '''single''' Groups, et les Children (enfants). PagingGroupsModel implémente cette interface. | |

| − | + | Lorsqu'une de ces méthodes est appelée, le PagingGroupsModel va vérifier si cette position est mise en cache pour la page courante et si pas, (re)charge un morceau de page de taille équivalente de données depuis la DB et les mes dans les caches respectives. | |

| − | + | Un problème apparaît ici, la taille des données récupérées de la DB ne correspond pas aux limites de la page dans l'UI. | |

e.g. | e.g. | ||

| Line 235: | Line 234: | ||

</source> | </source> | ||

| − | ''' | + | '''Taille de la page vs. Taille du groupe''': Alors que les pages de l'UI ont des tailles constantes, les groupes eux peuvent avoir des tailles variables, et leur offset peut être décalé à cause des nodes ouvert/fermé, l'offset des morceaux chargés depuis la DB vont varier lorsque l'état des nodes est modifié. |

| − | + | Vu que nous cherchons à profiter de la mise en cache à tous les niveaux possibles, gardons les paramètres des méthodes/requêtes constants et nous réduirons ainsi la taille de la cache nécessaire au niveau de la méthode Dao ou dans la DB, et cela permettra aussi d'éviter le chargement chevauché de groupes de données (avec des utilisateurs multiples qui ont des états UI différents). | |

| − | + | Donc, dans le scénario ci-dessus, lorsque p.e. Element 3 du Group 1 doit être chargé, le PagingGroupsModel va charger le groupe "Group1 Child0-9" en appelant this.loadChildrenPage(1, 0, 10). Parfait pour la mise en cache, vu qu'il n'appellera jamais p.e. this.loadChildrenPage(1, 3, 10). | |

| − | + | Voir: | |

* AccessDataGroupsModel#loadGroupPage(int startIndex, int pageSize) | * AccessDataGroupsModel#loadGroupPage(int startIndex, int pageSize) | ||

* AccessDataGroupsModel#loadChildrenPage(int groupIndex, int startIndex, int pageSize) | * AccessDataGroupsModel#loadChildrenPage(int groupIndex, int startIndex, int pageSize) | ||

| − | + | La même stratégie s'applique pour la mise en cache des Groups. PagingGroupsModel va aussi charger un ensemble de Groups avec des intervalles fixes. Si les groupes sont affichés avec un 'foot', la taille en cache des groupes peut être réduite de moitié vu que le foot du groupe va aussi consommer une ligne. | |

<source language="java"> | <source language="java"> | ||

| Line 252: | Line 251: | ||

</source> | </source> | ||

| − | + | La taille de la cache est raisonnablement petite et le LRUMap va s'assurer qu'elle ne grossit pas au-delà de ses capacités en éliminant les vieux Groups/Children lorsqu'il y débordement. | |

| − | + | Le désavantage des cette approche est que, dans la plupart des cas, au moins deux ensembles doivent être chargés pour afficher une seule page, cependant lors de la mise en cache d'un petit nombre, un des deux aura déjà été chargé pour la page précédente peut importe la direction dans laquelle vous naviguez. | |

| − | + | Je pense que la meilleur possibilité de mise en cache élimine le léger dépassement de mémoire. Sur une page de taille 50, on pourrait avoir 49 enregistrements de trop en mémoire (qui seront peut-être réutilisés sur la page suivante lorsque l'utilisateur navigue ou par une autre Page). Mais réduire les permutations des paramètres des méthodes/requêtes par 98%, ce qui augmente fortement la nécessité de cache, a un impact au niveau de la méthode ou de la DB. Je garderai même la cache plus grande de sorte qu'en cas de navigation arrière, cela n'engendre pas de rechargement. | |

| − | + | Aussi, des groupes très petits engendrerons plus d'aller-retours vers la DB, mais bon ... on parle ici de GROSSES quantités de données :) | |

| − | == | + | ==Pagination à accès aléatoire== |

| − | + | Lors d'une simple navigation page par page, ce serait déjà suffisant... mais si vous voulez naviguer vers la page no 234.455.234 ? :-o | |

| − | + | Il n'y a pas de problèmes quand les Groups sont fermés par défaut vu que chaque groupe consiste simplement en un Head (entête) (ou Head et Foot). | |

| − | + | Si, par défaut, les pages sont ouvertes, vous est soudainement confronté à une question à laquelle vous n'auriez même pas songé avant, lorsque vous faisiez de la pagination sur une liste plate sans le niveau de groupement - plus quelques groupes ouvert/fermé. | |

| − | '' | + | ''Avec quel index de groupe- / enfant la page X démarre-t-elle??'' |

| − | + | La manière brute qui consiste à itérer sur tous les groupes en accumulant leurs tailles jusqu'à atteindre le nombre adéquat (page * TailleDePage) n'est pas réalisable. | |

| − | + | Cela va provoquer beaucoup d'opération DB ou un grand travail sur un grand nombre de compteurs de groupes. (Gardons en mémoire qu'on ne connait pas le nombre de groupCounts à accumuler pour atteindre la page X). | |

| − | + | Je ne suis pas un expert DB, il existe donc peut-être déjà une solution à ce problème au niveau de la DB (et nous devrions ajuster ce résultat en fonction du nombre de nœuds fermés que la DB ne connait d'ailleurs pas) et je ne suis pas un scientifique, il y a donc peut-être aussi un algorithme de recherche plus sophistiqué - Merci de commenter si vous en connaissez un :) | |

| − | + | Voici donc mon approche qui va garder le nombre d'opérations DB requises à un niveau faible et qui augmentera les chances de trouver dans la cache, en particulier pour les opération de comptage qui sont très coûteuses et très récurrentes. | |

| − | + | Une recherche binaire: | |

| − | 1. | + | 1. Découpez le nombre de groupes en "Ranges" et laisser la DB compter le nombre de lignes pour ce "Range" |

| − | : ( | + | : (Je suis certain que la DB est plus rapide que vous avec le code java (en supposant une indexation efficace) ;)) p.e. |

: <code>SELECT count(*) WHERE group_key >= x AND group_key < y</code> | : <code>SELECT count(*) WHERE group_key >= x AND group_key < y</code> | ||

| − | 2. | + | 2. Regardez si le résultat (ajusté en fonction des group-heads(, -feet) et les groupes dont l'état a été inversé) est plus grand ou plus petit. |

| − | 3. | + | 3. Définissez le plus petit "Range" suivant en continuant le découpage en deux des intervalles. |

| − | + | Répétez 1 à 3 jusqu'à ce que vous trouviez le groupe. | |

| − | * | + | * Pour 1024 groupes, vous n'aurez pas à le faire plus de 9 fois avant de trouver le groupe qui vous intéresse. |

| − | * | + | * Pour 1024 * 1024 (environ un million) c'est seulement 19 fois |

| − | * | + | * Pour 1024 * 1024 * 1024 (environ un milliard) c'est seulement 29 fois |

| − | + | Vous voyez donc bien ces échelles de 2x la donnée qui nécessitent seulement un aller-retour supplémentaire dans la DB. | |

| − | + | En démarrant avec 1024 Groups, une séquence possible de "ranges" serait | |

# 0 < 512 (WHERE group_key >= 0 AND group_key < 512) | # 0 < 512 (WHERE group_key >= 0 AND group_key < 512) | ||

# 0 < 256 ... | # 0 < 256 ... | ||

| Line 304: | Line 303: | ||

# 156 < 160 | # 156 < 160 | ||

# 156 < 158 | # 156 < 158 | ||

| − | # 157 < 158 :D | + | # 157 < 158 :D le début de la page se trouve dans le groupe #157 |

| − | + | Une autre conséquence positive: les requêtes les plus complexes n'auront que peu de variation dans leurs paramètres, elle seront donc pratiquement déjà en cache, et la consommation mémoire pour une entrée dans la cache est très faible... 3 entiers (début de range et fin de range comme clé de cache et un autre entier pour le compteur) -> Mettre en cache quelques centaines (ou milliers) de ces résultats ne pèse pas trop lourd en comparaison avec la mise en cache de chaque compteur de groupe dans la mémoire (ça dépend de la DB) | |

| − | + | La 1ère requête est toujours la même, | |

| − | + | La 2ème requête a seulement deux options, | |

| − | + | La 3ème requête a 4 options, | |

... | ... | ||

| − | + | Nous avons certes une pénalité de quelques requêtes DB pour un accès aléatoire à une page, mais après cela, la cache est prête et la navigation sur une page unique prendra un chemin similaire dans la recherche binaire, provoquant moins de ratés dans la cache (à l’exception e quelques cas rares, lorsque vous passez la limite d'un range plus gros, mais la pénalité ne sera jamais aussi grosse que la première requête). De plus, les "ranges" seront les mêmes pour des utilisateurs concurrents, donnant aussi la possibilité de mettre en cache à un niveau applicatif plus bas. | |

| − | + | Vu que l'utilisateur va plus que probablement démarrer depuis la première page, j'ai ajouté une approche alternative en commençant du groupe zéro, comme une recherche de bas en haut, doublant les "ranges" à chaque itération jusqu'à ce que l'index de recherche soit dépassé et ensuite affine le résultat en réutilisant l'approche binaire. | |

| − | + | Ceci reporte les opération de comptage très coûteuses à un moment où "un accès aléatoire survient"... comme j'ai dit je ne suis pas un scientifique, j'ai donc défini un seuil pour le searchIndex. Pour des index de recherches plus grands, la recherche de haut en bas est utilisée. | |

| − | + | Dans le cas où quelqu'un aurait une meilleure stratégie, j'ai extrait l’interface GroupingPositionSearch pour que tout le monde puisse l'implémenter par lui-même (peut-être une procédure pure de stockage en DB). | |

| − | + | Voir: | |

* org.zkoss.grouping.model.search.GroupingPositionSearch | * org.zkoss.grouping.model.search.GroupingPositionSearch | ||

* org.zkoss.grouping.model.search.LinearGroupingPositionSearch | * org.zkoss.grouping.model.search.LinearGroupingPositionSearch | ||

| − | : | + | : une implémentation pour le fun... pour comparer la différence des performances |

* org.zkoss.grouping.model.search.BinaryGroupingPositionSearch | * org.zkoss.grouping.model.search.BinaryGroupingPositionSearch | ||

| − | : | + | : les seuls besoins sont d'implémenter la méthode getChildCountBetween() et interroger la DB |

| − | + | Assez de blabla pseudo-théorique ... utilisons cela! | |

| − | = | + | =Utiliser le Model dans l'UI= |

| − | + | Nous avons vu comment accéder aux données et comment la mise en cache devrait avoir des effets positifs. Il reste donc à voir le ViewModel et le View. | |

==accesslog_mvvm.zul== | ==accesslog_mvvm.zul== | ||

| Line 381: | Line 380: | ||

</source> | </source> | ||

| − | + | Comme vous pouvez le voir, c'est simplement une Grouping Grid de base qui n'utilise pas le moule "paging" mais un contrôle de pagination séparé vu qu'on envoie seulement un Model délégué (model="@load(vm.currentPageModel)") au composant <grid>. On fait ceci pour présenter au composant grid aussi peu d'informations que possible, ce qui lui évite de mettre en cache interne des données et aussi d'avoir le contrôle total de ce qui est chargé. | |

| − | + | Vu que le composant Grid s'attend à ce que les groupes s'ouvrent et se ferment de façon cohérente, un en-tête et/ou pied de page nominal doit être ajouté si une Page ne commence pas avec un début de groupe ou ne s'achève pas avec une fin de groupe. (c'est assez déplaisant, mais qu'avons nous en retour) ... la plus grande grille de groupement ZK de tous les temps. | |

==AccessDataGroupingViewModel== | ==AccessDataGroupingViewModel== | ||

| Line 447: | Line 446: | ||

</source> | </source> | ||

| − | + | A part l'appel quelque peu douteux à groupsModel.getSinglePageModel() pour recevoir les faux groupes de données, il n'y a rien de remarquable ici: | |

| − | * | + | * initialisation du model |

| − | * | + | * gestion des paging events (updateOffsetIndex(x) dans le page model délégué) |

| − | + | Le reste est fait dans PagingGroupsModel. | |

| − | = | + | =Lancer l'application démo= |

| − | == | + | ==En utilisant Maven== |

| − | + | Dézippez le Package et exécutez la commande mnv suivante: | |

mvn jetty:run | mvn jetty:run | ||

| − | + | Ouvrez cette URL dans un naviguateur: | |

: http://localhost:8080/hugeGrouping/accesslog_mvvm.zul | : http://localhost:8080/hugeGrouping/accesslog_mvvm.zul | ||

| − | + | L'application sera efficace lorsque vous ouvrirez/fermerez des groupes, peut importe l'endroit où vous naviguez. Jetez un coup d’œil à la console des logs pour avoir des informations sur la cache. Notez le nombre élevé de trouvailles dans la cache après une navigation aléatoire dans une page et en visitant ensuite les pages suivantes/précédentes. | |

| − | + | La configuration initiale d'AccessLogDao (mock) est de 40 millions de groupes avec 8 à 88 enfants distribués de façon aléatoire. On a donc environ 2 milliards de lignes. | |

| − | + | La consommation mémoire restera stable quand le Dao sera initialisé (ces 160MB - mentionnés plus haut - devraient habituellement se trouver dans la DB et non dans la mémoire) lors de la navigation dans la liste. | |

| − | + | Lorsque la cache de la recherche de position de groupes tourne à plein rendement, le nombre d'appels vers la DB est faible (de 1 à 4 fois plus petit) par page incrémentée / décrémentée, après un accès aléatoire à une page arbitraire (à part quelques cas spéciaux - dépasser les limites d'une grande région de recherche binaire). | |

| − | + | Les données renvoyées par la DB sont très petites: | |

| − | * | + | * charger 1 ou 2 (ou quelques très petits) morceaux des groupes enfants (chacun de la taille de la page) |

| − | * | + | * charger 0 ou 1 nouveau(x) morceau(x) (de la taille de page) d'information de groupes (sans la charge que représente les enfants) |

| − | * | + | * généralement un petit nombre de requêtes qui évite les MISSES au cours de la recherche binaire pour l'index de début de la page suivante. |

| − | ** | + | ** En tenant compte des incréments/décréments de pages simples, on peut améliorer ceci avec un gestionnaire d’événement de pagination. Pour garder l'exemple simple, on traite chaque recherche de position comme étant un accès aléatoire et nous gardons toujours une bonne performance sans traitement spécifique. |

| − | ==War | + | ==Fichier War== |

| − | + | Si vous ne pouvez pas (ne voulez pas) utiliser maven, il y a aussi un ficher war disponible pour téléchargement. Il peut être déployé dans un serveur d'applications web existant (p.e. [[http://tomcat.apache.org/download-70.cgi Tomcat]]) | |

=Appendix= | =Appendix= | ||

| − | == | + | ==Téléchargement== |

| − | + | Télécharger le projet maven [http://sourceforge.net/projects/zkforge/files/Small%20Talks/Huge%20Data%20Grouping/hugeGrouping.zip/download hugeGrouping.zip (~24.7 kB)] | |

| − | + | Télécharger le fichier war [http://sourceforge.net/projects/zkforge/files/Small%20Talks/Huge%20Data%20Grouping/hugeGrouping.war/download hugeGrouping.war (~25 MB)] | |

| − | = | + | =Commentaires= |

{{#tag:comment | {{#tag:comment | ||

|http://books.zkoss.org/wiki/{{SUBJECTPAGENAME}}|disqus=1 | |http://books.zkoss.org/wiki/{{SUBJECTPAGENAME}}|disqus=1 | ||

Latest revision as of 05:59, 8 April 2014

Robert Wenzel, Engineer, Potix Corporation

September 24, 2013

ZK 6.5 (or later)

Introduction

Vous avez parfois une énorme quantité de données dans votre base de données et vous souhaitez les afficher dans une Grid ou une Listbox ZK en utilisant le groupement de données. Bien entendu, vous souhaitez utiliser une pagination parce-que la liste est bien trop grande que pour être affichée sur une seule page. Ou alors, vous voulez éviter un message 'timeout' ou "OutOfMemoryError" lors de la lecture / du parcours de ce grand nombre d'enregistrements (voir même un nombre inconnu).

Pour une liste simple, référez vous à ce sujet déjà abordé dans le Small Talks içi.

Sur bases des certains concepts (pagination au niveau de la DB et séparation du contrôle de la pagination de la grid) cet article propose une stratégie et présente un exemple implémenté de comment faire du groupement de données à l'identique.

Cependant, les choses se compliquent ici quelques peu... j'espère donc au final donner une idée de comment ZK masque les parties compliquées, et laisse le développeur se concentrer sur la récupération et l'affichage des données.

Les défis

Le Groupement est une caractéristique puissante de ZK mais qui amène aussi une couche supplémentaire de complexité.

Certains pourraient se demander s'il est utile d'afficher une liste aussi longue de cette manière (en particulier sans pré-filtrage des résultats).

Nous sommes ici pour montrer que c'est possible possible, jusqu'à quelles limites ... et bien, ZK GroupsModel supporte des index de type int, nous pouvons donc aller jusqu'à environ Integer.MAX_VALUE (~ 2.000.000.000 enregistrements - 2 milliards)

Les défis de la pagination et du regroupement

1. Les groupes peuvent être ouverts ou fermés (initialement ou de façon interactive)

- -> Le nombre total et le nombre de pages changent à l'ouverture/la fermeture des nœuds d'index (nodes)... ceci requiert un comptage efficace et continuellement à jour

2. Les groupes peuvent avoir un nombre arbitraire d'enfants

- -> L'accès aléatoire à une page spécifique peut devenir délicat ... comment connaitre le groupe actuel et la position à l'intérieur de ce groupe pour cette page

- --> Comment implémenter une recherche réalisable ?

3. Minimiser les opérations DB (accumulation des latences réseau/DB)

- -> Prendre en considération la mise en cache versus la consommation de la mémoire

1. + 2. + 3. Cet article va expliquer comment combiner ces trois aspects de manière efficace en préservant la mémoire (presque prévisible) et quelques compromis qui doivent être faits. Aussi, quelques points d'extension sont mis en évidence, où, si possible, la mise en oeuvre d'usage général peut être remplacée par une autre plus spécifique, en fonction des détails de votre propre modèle de données.

Quelques limites

- Cet exemple fonctionne uniquement sur des données statiques - si les données changent, le modèle doit être réinitialisé et les caches doivent être vidées.

- Vu que toutes les lignes ne sont pas présentes en mémoire, vous pouvez envoyer des événements UI à des composants qui ne sont pas affichés à l'écran (vous manipulez l'état du modèle à la place)

- L'état ouvert/fermé est stocké en mémoire ("les humains ont des limites", il est peu probable de dépasser les 100 groupes) - Il ne devrait donc pas y avoir de problème.

- Certains composants "maquettes" sont nécessaires pour que le <grid> accepte la vue limitée (fenêtrée) sur les données.

Implémentation

Le package exemple est un projet maven, avec la structure suivante:

Le dossier "src" contient les différents fichiers/dossiers/packages:

Classes génériques (expliqué plus bas):

- org.zkoss.grouping.model

- implémentation pagination générique GroupsModel

- org.zkoss.grouping.model.search

- implémentation des recherches de positions

Implémentations spécifiques à l'exemple (montrant l'utilisation des éléments ci-dessus)

- org.zkoss.grouping.dao

- Classe Dao en mémoire qui simule des grosses quantités de données

- org.zkoss.grouping

- Les implémentation du Composer actuel (MVC) / ViewModel (MVVM) et (Dao-backed) PagingGroupsModel

Fichiers ZUL correspondants (dans src/main/webapp):

- accesslog.zul

- utilisation MVC de PagingGroupsModel

- accesslog_mvvm.zul

- utilisation MVVM de PagingGroupsModel avec DelegatingSinglePageGroupsModel

- accesslog_mvvm_default_paging.zul

- Exemple MVVM mettant en évidence les problèmes de performance sans contrôle de pagination séparé, en utilisant un set de données plus petit

Accéder aux données

Data Record et Dao

Nous commencons avec un simple enregistrement de données représentant des access logs.

package org.zkoss.grouping.dao;

import java.util.Date;

public class AccessDataRecord {

private String ipAddress;

private String browser;

private long contentLength;

private String country;

private Date accessTime;

private String url;

//... Constructor + getters

L'AccessDataDao est une implémentation mock générant les données à la volée sans utiliser une DB (juste des valeurs aléatoires) et qui stocke la taille des groupes en mémoire.

Donc, en oubliant la génération de données aléatoire, votre Dao devrait implémenter les 5 opérations suivantes suivant des requêtes SQL/HQL/Criteria/noSQL. Je suis conscient que compter des grandes quantités de données au niveau de la DB n'est pas chose simple. Il faut toujours préparer les données au niveau de la DB: ex. indexation propre, pré agrégation des groupes/compteurs (rien en quoi le 'front end framework' peut vous aider).

package org.zkoss.grouping.dao;

public class AccessLogDao {

public int getGroupCount() {

//your DB query to count the groups

}

public List<GroupInfo<String, String>> getGroupInfos(int startIndex, int pageSize) {

//your DB query and mapping to create GroupInfos for this page of groups

}

public List<AccessDataRecord> getChildInfos(int groupIndex, int startIndex, int pageSize) {

//your DB query and load this page of children in the group

}

/**

* This method will count a lot and return a constant value as long as data does not change,

* so caching would be desirable

* @return

*/

public int getTotalChildCount() {

//your DB impl to calc the total number of children

}

/**

* This method will be called quite often with recurring parameters,

* so caching (of most frequently used params) would be desirable !!!

* @return the childrenCount between 2 groups... (including groupIndexFrom and excluding groupIndexTo)

*/

public int getChildCountBetween(int groupIndexFrom, int groupIndexTo) {

//your DB impl to calc the number of children between 2 groups

}

Le modèle de pagination

AccessDataGroupsModel, notre PagingGroupsModel<D, H, F> spécialisé utilise une implémentation d'AccessDataRecord comme "data"(D) et String comme "head"(H) et "foot"(F). Cette classe implémente les 4 méthodes du modèle et une stratégie GroupingPositionSearch - tout en déléguant à AccessLogDao d'en haut, pour garder la charge de travail au niveau de la DB.

package org.zkoss.grouping;

import java.util.List;

import org.zkoss.grouping.dao.AccessLogDao;

import org.zkoss.grouping.dao.AccessDataRecord;

import org.zkoss.grouping.model.GroupInfo;

import org.zkoss.grouping.model.PagingGroupsModel;

import org.zkoss.grouping.model.search.BinaryGroupingPositionSearch;

import org.zkoss.grouping.model.search.GroupingPositionSearch;

class AccessDataGroupsModel extends

PagingGroupsModel<AccessDataRecord, String, String> {

private AccessLogDao groupsDao;

public AccessDataGroupsModel(AccessLogDao groupsDao, int pageSize, boolean initialOpen, boolean hasGroupfoot) {

super(pageSize, initialOpen, hasGroupfoot);

this.groupsDao = groupsDao;

setPositionSearch(binarySearch());

}

@Override

protected int loadGroupCount() {

return groupsDao.getGroupCount();

}

@Override

protected List<GroupInfo<String, String>> loadGroupPage(int startIndex, int pageSize) {

return groupsDao.getGroupInfos(startIndex, pageSize);

}

@Override

protected List<AccessDataRecord> loadChildrenPage(int groupIndex, int startIndex, int pageSize) {

return groupsDao.getChildInfos(groupIndex, startIndex, pageSize);

}

@Override

protected int getTotalChildCount() {

return groupsDao.getTotalChildCount();

}

private GroupingPositionSearch binarySearch() {

return new BinaryGroupingPositionSearch(this, 4096) {

@Override

protected int getChildCountBetween(int groupIndexFrom, int groupIndexTo) {

return groupsDao.getChildCountBetween(groupIndexFrom, groupIndexTo);

}

};

}

}

Comme nous pouvons le voir, les méthodes se concentrent sur le comptage et la récupération des données dans des morceaux de la taille d'une page. Rien de magique ici, pendant que notre DB fait le travaille difficile (sélection, groupement, comptage, tri) ... c'est à ça que ça sert. Et avec des grosses quantités de données, nous n'allons pas essayer de battre la DB, nous voulons seulement des données aussi petites que possible. Votre administrateur DB sera heureux de vous aider à optimiser vos requêtes et préparer vos données. ;-)

Page/Caching, Comptage & conserver l'état ouvert/fermé

Conserver l'état ouvert/fermé

Le PagingGroupsModel va garder une trace des états ouvert/fermé pour les groupes dont l'état a été modifié (avec en même-temps le childCount de ce groupe).

Si le Model est initialisé avec INITIALLY_OPEN, alors on gardera la trace uniquement des 'nodes' fermés, et vice versa.

En supposant qu'un humain ne prendra pas le temps de changer l'état d'un nombre immense de groupes, cette Map (groupIndex => childcount) restera relativement petite et ne devrait pas compromettre notre performance ainsi que nos attentes au niveau de la mémoire. De plus, le nombre total de groupes dont l'état a été modifié est mis à jour à chaque interaction ouvert/fermé.

Cette information est utilisée pour ajuster le nombre total d'enfants (pour le calcul de pagination UI) ou le nombre d'enfants entre deux groupes (pour la recherche de Position) - vu que la DB ne gardera pas cet état UI.

Voir:

- PagingGroupsModel#getCurrentRowCount()

- PagingGroupsModel#getToggledCountBetween(int groupIndexFrom, int groupIndexTo)

- PagingGroupsModel#toggleGroup(int groupIndex, boolean open)

Page/Caching

L'interface GroupsModel (ZK default) offre des méthodes pour récupérer les single Groups, et les Children (enfants). PagingGroupsModel implémente cette interface. Lorsqu'une de ces méthodes est appelée, le PagingGroupsModel va vérifier si cette position est mise en cache pour la page courante et si pas, (re)charge un morceau de page de taille équivalente de données depuis la DB et les mes dans les caches respectives.

Un problème apparaît ici, la taille des données récupérées de la DB ne correspond pas aux limites de la page dans l'UI.

e.g.

1 2 3 4

|.........|.........|.........|......... -> UI pages (page size 10)

0.....1.........|......2...3......4....5 -> Groups | Chunks Group 0 open

01.........|......2...3......4....5..... -> Groups | Chunks Group 0 closedTaille de la page vs. Taille du groupe: Alors que les pages de l'UI ont des tailles constantes, les groupes eux peuvent avoir des tailles variables, et leur offset peut être décalé à cause des nodes ouvert/fermé, l'offset des morceaux chargés depuis la DB vont varier lorsque l'état des nodes est modifié.

Vu que nous cherchons à profiter de la mise en cache à tous les niveaux possibles, gardons les paramètres des méthodes/requêtes constants et nous réduirons ainsi la taille de la cache nécessaire au niveau de la méthode Dao ou dans la DB, et cela permettra aussi d'éviter le chargement chevauché de groupes de données (avec des utilisateurs multiples qui ont des états UI différents).

Donc, dans le scénario ci-dessus, lorsque p.e. Element 3 du Group 1 doit être chargé, le PagingGroupsModel va charger le groupe "Group1 Child0-9" en appelant this.loadChildrenPage(1, 0, 10). Parfait pour la mise en cache, vu qu'il n'appellera jamais p.e. this.loadChildrenPage(1, 3, 10).

Voir:

- AccessDataGroupsModel#loadGroupPage(int startIndex, int pageSize)

- AccessDataGroupsModel#loadChildrenPage(int groupIndex, int startIndex, int pageSize)

La même stratégie s'applique pour la mise en cache des Groups. PagingGroupsModel va aussi charger un ensemble de Groups avec des intervalles fixes. Si les groupes sont affichés avec un 'foot', la taille en cache des groupes peut être réduite de moitié vu que le foot du groupe va aussi consommer une ligne.

cachedGroups = Collections.synchronizedMap(new LRUMap(pageSize * (hasGroupFoot ? 1 : 2))); //cache at least 2 pages ...

cachedChildren = Collections.synchronizedMap(new LRUMap(pageSize * 4)); //cache enough for at least a few pagesLa taille de la cache est raisonnablement petite et le LRUMap va s'assurer qu'elle ne grossit pas au-delà de ses capacités en éliminant les vieux Groups/Children lorsqu'il y débordement.

Le désavantage des cette approche est que, dans la plupart des cas, au moins deux ensembles doivent être chargés pour afficher une seule page, cependant lors de la mise en cache d'un petit nombre, un des deux aura déjà été chargé pour la page précédente peut importe la direction dans laquelle vous naviguez.

Je pense que la meilleur possibilité de mise en cache élimine le léger dépassement de mémoire. Sur une page de taille 50, on pourrait avoir 49 enregistrements de trop en mémoire (qui seront peut-être réutilisés sur la page suivante lorsque l'utilisateur navigue ou par une autre Page). Mais réduire les permutations des paramètres des méthodes/requêtes par 98%, ce qui augmente fortement la nécessité de cache, a un impact au niveau de la méthode ou de la DB. Je garderai même la cache plus grande de sorte qu'en cas de navigation arrière, cela n'engendre pas de rechargement.

Aussi, des groupes très petits engendrerons plus d'aller-retours vers la DB, mais bon ... on parle ici de GROSSES quantités de données :)

Pagination à accès aléatoire

Lors d'une simple navigation page par page, ce serait déjà suffisant... mais si vous voulez naviguer vers la page no 234.455.234 ? :-o

Il n'y a pas de problèmes quand les Groups sont fermés par défaut vu que chaque groupe consiste simplement en un Head (entête) (ou Head et Foot).

Si, par défaut, les pages sont ouvertes, vous est soudainement confronté à une question à laquelle vous n'auriez même pas songé avant, lorsque vous faisiez de la pagination sur une liste plate sans le niveau de groupement - plus quelques groupes ouvert/fermé.

Avec quel index de groupe- / enfant la page X démarre-t-elle??

La manière brute qui consiste à itérer sur tous les groupes en accumulant leurs tailles jusqu'à atteindre le nombre adéquat (page * TailleDePage) n'est pas réalisable. Cela va provoquer beaucoup d'opération DB ou un grand travail sur un grand nombre de compteurs de groupes. (Gardons en mémoire qu'on ne connait pas le nombre de groupCounts à accumuler pour atteindre la page X).

Je ne suis pas un expert DB, il existe donc peut-être déjà une solution à ce problème au niveau de la DB (et nous devrions ajuster ce résultat en fonction du nombre de nœuds fermés que la DB ne connait d'ailleurs pas) et je ne suis pas un scientifique, il y a donc peut-être aussi un algorithme de recherche plus sophistiqué - Merci de commenter si vous en connaissez un :)

Voici donc mon approche qui va garder le nombre d'opérations DB requises à un niveau faible et qui augmentera les chances de trouver dans la cache, en particulier pour les opération de comptage qui sont très coûteuses et très récurrentes.

Une recherche binaire:

1. Découpez le nombre de groupes en "Ranges" et laisser la DB compter le nombre de lignes pour ce "Range"

- (Je suis certain que la DB est plus rapide que vous avec le code java (en supposant une indexation efficace) ;)) p.e.

SELECT count(*) WHERE group_key >= x AND group_key < y

2. Regardez si le résultat (ajusté en fonction des group-heads(, -feet) et les groupes dont l'état a été inversé) est plus grand ou plus petit.

3. Définissez le plus petit "Range" suivant en continuant le découpage en deux des intervalles.

Répétez 1 à 3 jusqu'à ce que vous trouviez le groupe.

- Pour 1024 groupes, vous n'aurez pas à le faire plus de 9 fois avant de trouver le groupe qui vous intéresse.

- Pour 1024 * 1024 (environ un million) c'est seulement 19 fois

- Pour 1024 * 1024 * 1024 (environ un milliard) c'est seulement 29 fois

Vous voyez donc bien ces échelles de 2x la donnée qui nécessitent seulement un aller-retour supplémentaire dans la DB.

En démarrant avec 1024 Groups, une séquence possible de "ranges" serait

- 0 < 512 (WHERE group_key >= 0 AND group_key < 512)

- 0 < 256 ...

- 128 < 192

- 128 < 160

- 144 < 160

- 152 < 160

- 156 < 160

- 156 < 158

- 157 < 158 :D le début de la page se trouve dans le groupe #157

Une autre conséquence positive: les requêtes les plus complexes n'auront que peu de variation dans leurs paramètres, elle seront donc pratiquement déjà en cache, et la consommation mémoire pour une entrée dans la cache est très faible... 3 entiers (début de range et fin de range comme clé de cache et un autre entier pour le compteur) -> Mettre en cache quelques centaines (ou milliers) de ces résultats ne pèse pas trop lourd en comparaison avec la mise en cache de chaque compteur de groupe dans la mémoire (ça dépend de la DB)

La 1ère requête est toujours la même, La 2ème requête a seulement deux options, La 3ème requête a 4 options, ...

Nous avons certes une pénalité de quelques requêtes DB pour un accès aléatoire à une page, mais après cela, la cache est prête et la navigation sur une page unique prendra un chemin similaire dans la recherche binaire, provoquant moins de ratés dans la cache (à l’exception e quelques cas rares, lorsque vous passez la limite d'un range plus gros, mais la pénalité ne sera jamais aussi grosse que la première requête). De plus, les "ranges" seront les mêmes pour des utilisateurs concurrents, donnant aussi la possibilité de mettre en cache à un niveau applicatif plus bas.

Vu que l'utilisateur va plus que probablement démarrer depuis la première page, j'ai ajouté une approche alternative en commençant du groupe zéro, comme une recherche de bas en haut, doublant les "ranges" à chaque itération jusqu'à ce que l'index de recherche soit dépassé et ensuite affine le résultat en réutilisant l'approche binaire. Ceci reporte les opération de comptage très coûteuses à un moment où "un accès aléatoire survient"... comme j'ai dit je ne suis pas un scientifique, j'ai donc défini un seuil pour le searchIndex. Pour des index de recherches plus grands, la recherche de haut en bas est utilisée.

Dans le cas où quelqu'un aurait une meilleure stratégie, j'ai extrait l’interface GroupingPositionSearch pour que tout le monde puisse l'implémenter par lui-même (peut-être une procédure pure de stockage en DB).

Voir:

- org.zkoss.grouping.model.search.GroupingPositionSearch

- org.zkoss.grouping.model.search.LinearGroupingPositionSearch

- une implémentation pour le fun... pour comparer la différence des performances

- org.zkoss.grouping.model.search.BinaryGroupingPositionSearch

- les seuls besoins sont d'implémenter la méthode getChildCountBetween() et interroger la DB

Assez de blabla pseudo-théorique ... utilisons cela!

Utiliser le Model dans l'UI

Nous avons vu comment accéder aux données et comment la mise en cache devrait avoir des effets positifs. Il reste donc à voir le ViewModel et le View.

accesslog_mvvm.zul

<window border="normal" height="810px" width="1200px"

apply="org.zkoss.bind.BindComposer" viewModel="@id('vm')

@init('org.zkoss.grouping.AccessDataGroupingViewModel')">

<paging pageSize="@load(vm.pageSize)"

activePage="@bind(vm.activePage)"

totalSize="@load(vm.totalSize)"

onPaging="@command('changePage', activePage=event.activePage)"

detailed="true" />

<grid model="@load(vm.currentPageModel)" >

<columns>

<column label="ip" ></column>

<column label="url" ></column>

<column label="time" ></column>

<column label="country" ></column>

<column label="browser" ></column>

<column label="length" ></column>

</columns>

<template name="model:group">

<group label="@init(each)" visible="@init(not(vm.isDummy(each)))" ></group>

</template>

<template name="model">

<row>

<label value="@init(each.ipAddress)"></label>

<label value="@init(each.url)"></label>

<label value="@init(each.accessTime)"></label>

<label value="@init(each.country)"></label>

<label value="@init(each.browser)"></label>

<label value="@init(each.contentLength)"></label>

</row>

</template>

<template name="model:groupfoot">

<groupfoot visible="@init(not(vm.isDummy(each)))">

<cell colspan="6" sclass="z-groupfoot-inner">

<label value="@init(each)" sclass="z-groupfoot-cnt" />

</cell>

</groupfoot>

</template>

</grid>

</window>Comme vous pouvez le voir, c'est simplement une Grouping Grid de base qui n'utilise pas le moule "paging" mais un contrôle de pagination séparé vu qu'on envoie seulement un Model délégué (model="@load(vm.currentPageModel)") au composant <grid>. On fait ceci pour présenter au composant grid aussi peu d'informations que possible, ce qui lui évite de mettre en cache interne des données et aussi d'avoir le contrôle total de ce qui est chargé.

Vu que le composant Grid s'attend à ce que les groupes s'ouvrent et se ferment de façon cohérente, un en-tête et/ou pied de page nominal doit être ajouté si une Page ne commence pas avec un début de groupe ou ne s'achève pas avec une fin de groupe. (c'est assez déplaisant, mais qu'avons nous en retour) ... la plus grande grille de groupement ZK de tous les temps.

AccessDataGroupingViewModel

public class AccessDataGroupingViewModel {

private static final String DUMMY_FOOT = new String();

private static final String DUMMY_HEAD = new String();

//TODO: inject

private AccessLogDao groupsDao = AccessLogDao.getInstance();

private PagingGroupsModel<AccessDataRecord, String, String> groupsModel;

private int pageSize;

private int activePage;

private DelegatingSinglePageGroupsModel<AccessDataRecord, String, String> currentPageModel;

@Init

public void init() {

pageSize = 20;

activePage = 0;

groupsModel = new AccessDataGroupsModel(groupsDao, pageSize,

PagingGroupsModel.INITIALLY_OPEN, PagingGroupsModel.GROUPFOOT_ON);

currentPageModel = groupsModel.getSinglePageModel(DUMMY_HEAD, DUMMY_FOOT, this, "totalSize");

refreshRows();

}

@Command("changePage")

@NotifyChange("currentPageModel")

public void onChangePage() {

refreshRows();

}

private void refreshRows() {

currentPageModel.updateOffsetIndex(activePage * pageSize);

}

public int getPageSize() {

return pageSize;

}

public int getActivePage() {

return activePage;

}

public void setActivePage(int activePage) {

this.activePage = activePage;

}

public int getTotalSize() {

return groupsModel.getCurrentRowCount();

}

public GroupsModel<AccessDataRecord, String, String> getCurrentPageModel() {

return currentPageModel;

}

public boolean isDummy(String string) {

return DUMMY_HEAD == string || DUMMY_FOOT == string ;

}

}A part l'appel quelque peu douteux à groupsModel.getSinglePageModel() pour recevoir les faux groupes de données, il n'y a rien de remarquable ici:

- initialisation du model

- gestion des paging events (updateOffsetIndex(x) dans le page model délégué)

Le reste est fait dans PagingGroupsModel.

Lancer l'application démo

En utilisant Maven

Dézippez le Package et exécutez la commande mnv suivante:

mvn jetty:run

Ouvrez cette URL dans un naviguateur:

L'application sera efficace lorsque vous ouvrirez/fermerez des groupes, peut importe l'endroit où vous naviguez. Jetez un coup d’œil à la console des logs pour avoir des informations sur la cache. Notez le nombre élevé de trouvailles dans la cache après une navigation aléatoire dans une page et en visitant ensuite les pages suivantes/précédentes.

La configuration initiale d'AccessLogDao (mock) est de 40 millions de groupes avec 8 à 88 enfants distribués de façon aléatoire. On a donc environ 2 milliards de lignes.

La consommation mémoire restera stable quand le Dao sera initialisé (ces 160MB - mentionnés plus haut - devraient habituellement se trouver dans la DB et non dans la mémoire) lors de la navigation dans la liste. Lorsque la cache de la recherche de position de groupes tourne à plein rendement, le nombre d'appels vers la DB est faible (de 1 à 4 fois plus petit) par page incrémentée / décrémentée, après un accès aléatoire à une page arbitraire (à part quelques cas spéciaux - dépasser les limites d'une grande région de recherche binaire).

Les données renvoyées par la DB sont très petites:

- charger 1 ou 2 (ou quelques très petits) morceaux des groupes enfants (chacun de la taille de la page)

- charger 0 ou 1 nouveau(x) morceau(x) (de la taille de page) d'information de groupes (sans la charge que représente les enfants)

- généralement un petit nombre de requêtes qui évite les MISSES au cours de la recherche binaire pour l'index de début de la page suivante.

- En tenant compte des incréments/décréments de pages simples, on peut améliorer ceci avec un gestionnaire d’événement de pagination. Pour garder l'exemple simple, on traite chaque recherche de position comme étant un accès aléatoire et nous gardons toujours une bonne performance sans traitement spécifique.

Fichier War

Si vous ne pouvez pas (ne voulez pas) utiliser maven, il y a aussi un ficher war disponible pour téléchargement. Il peut être déployé dans un serveur d'applications web existant (p.e. [Tomcat])

Appendix

Téléchargement

Télécharger le projet maven hugeGrouping.zip (~24.7 kB)

Télécharger le fichier war hugeGrouping.war (~25 MB)

Commentaires

| Copyright © Potix Corporation. This article is licensed under GNU Free Documentation License. |